灶台就是我的终端,炒锅是GPU,而每一次翻炒都在调整模型的参数。今天要训练的模型,代号“平度青海干拌”。目标:在味觉的测试集上,达到“锅气”与“清爽”两个指标的平衡,过拟合(太咸)和欠拟合(太淡)都是失败。

📊 第一阶段:数据收集与预处理 (20%)

任何可靠的模型,都始于一个干净的数据集。青海干拌的核心数据单元包括:碱水面条(300克,作为基础架构)、黄瓜丝(50克,提供清爽标签)、鸡胸肉(150克,蛋白质向量)、以及那碟灵魂——由芝麻酱、蒜泥、香醋和少许(对,就是那个“你觉得差不多”的量)盐混合而成的复合型酱料算法。

预处理流程如下:

→ 鸡胸肉:冷水下锅,加入姜片、料酒。煮沸后转小火,计时12分钟。这是**监督学习**,用明确的时间标签,让肉质达到“熟透但未柴”的最优解。

→ 黄瓜:切丝后,用少许盐腌制5分钟,挤掉水分。这一步叫**数据清洗**,去除多余的水分噪声,防止后续训练(拌制)时出现“水垮”的灾难性泛化错误。

→ 面条:沸水下锅,煮至8分熟。捞出,过凉水,沥干,拌入少许熟油。这是**数据标准化**和**防止粘连(过拟合)** 的关键步骤。

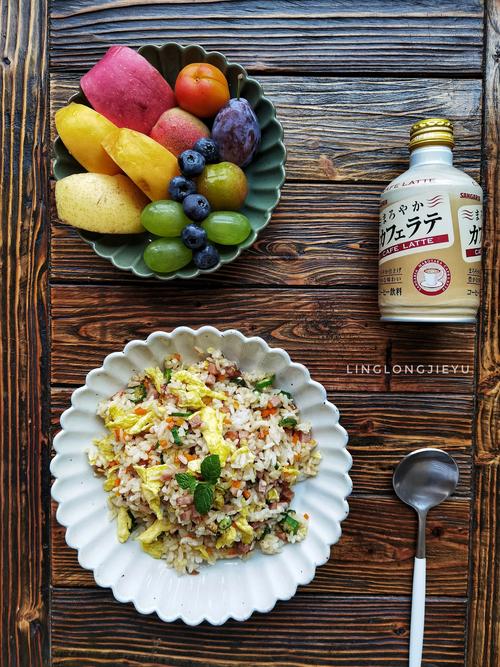

(图片来源网络,侵删)

⚙️ 第二阶段:模型架构选择 (25%)

面对一堆预处理好的数据,选择什么样的混合模型至关重要。是粗暴的“一锅端”全连接?还是分层的、有仪式感的顺序叠加?我选择后者,一种**分层融合模型**。

底层(碗底):先铺上黄瓜丝。它不抢味,像一层缓冲层,为后续的强烈风味提供对比基线。

中间层:码上撕成条状的鸡胸肉和煮好的面条。这是模型的主体,承载主要的营养与口感参数。

顶层(输出层):淋上酱料算法。这里是**注意力机制**的核心——芝麻酱负责醇厚,蒜泥提供尖锐的刺激,香醋带来酸性的梯度下降,避免口感陷入局部最优的“腻”。

传说,这种分层模型是灶神在调试人间烟火时发明的。最初他把所有食材和酱料扔进一个混沌的鼎里,结果得到了“麻辣烫”。后来他意识到,清晰的层次,才能让每一种风味在最终输出时,保持可解释性。

🔁 第三阶段:训练过程与调参 (30%)

训练开始。手持筷子,以腕部为轴心,进行匀速圆周运动。这不是简单的搅拌,而是**迭代优化**。

第一轮(30秒):从底部轻柔翻起,让底层的黄瓜丝与酱料初步接触。学习率不宜过高,否则底味会突然变得过咸(梯度爆炸)。

第二轮(45秒):加大幅度,将中层面条与鸡肉充分卷入。此时,酱料开始均匀包裹每一根面条。可以加入一勺煮鸡的清汤,作为**正则化项**,防止酱料过稠导致模型“板结”。

第三轮(15秒):快速收尾,确保没有未被酱料覆盖的“数据孤岛”。整个过程,就像在调整一个巨大的、有弹性的参数矩阵,直到每一根面条都挂上那种有点笨拙的、浅褐色的浓稠感。

📈 第四阶段:性能评估 (25%)

评估环节,没有标准的测试集。唯一的评估器是筷子尖挑起的第一口。

指标A:融合度。面条是否独立又统一?酱料是浮于表面,还是渗透进了内部?合格的输出,应该是入口时先感到芝麻酱的包裹,咀嚼中蒜的辛香才释放,最后以一丝醋的微酸收尾,层次清晰,推理路径明确。

指标B:平衡性。咸、香、酸、爽,四个维度是否达到了纳什均衡?任何一方的权重过高,都会宣告本次训练失败,需要回溯到“调参”(加醋或加汤)阶段。

指标C:锅气残留。尽管是凉拌,但鸡肉的温热与面条的余温,是否与酱料的凉形成了微妙的温差场?这是一种难以量化的“过拟合”于当下时刻的美好错误。

碗沿还沾着一抹没拌开的酱,我用手指抹下来,想着明天或许可以把它作为预训练权重,用来初始化一盘凉拌茄子的新模型……